在使用 ChatGPT 時,你一定會注意到模型對查詢的反應速度很慢。由於 LLM 的高延遲,Google Gemini 等在手機上使用的 AI ChatBox 甚至更慢。但 Groq 強大的新型 LPU 想要改變這件事。

Groq 的 LPU 推理引擎在運行 7B 模型時每秒可以生成 500 個tokens。而在運行 70B 模型時,每秒約為 250 個tokens。這與 OpenAI 的 ChatGPT 相去甚遠,ChatGPT 運行在由 GPU 驅動的 Nvidia 芯片上,每秒只能提供約 30 至 60 個 tokens。

Groq 由前 Google TPU 工程師建造

Groq 不是一個 AI 聊天機器人,而是一個 AI 推理芯片,它正在與像 Nvidia 這樣的行業巨頭在 AI 硬件領域競爭。它於 2016 年由 Jonathan Ross 共同創辦,他在 Google 工作期間共同創辦了建造 Google 首個用於機器學習的 TPU(Tensor Processing Unit)芯片的團隊。後來,許多員工離開了 Google 的 TPU 團隊,並創建了 Groq,為下一代計算建造硬件。

Groq 的 LPU 是什麼?

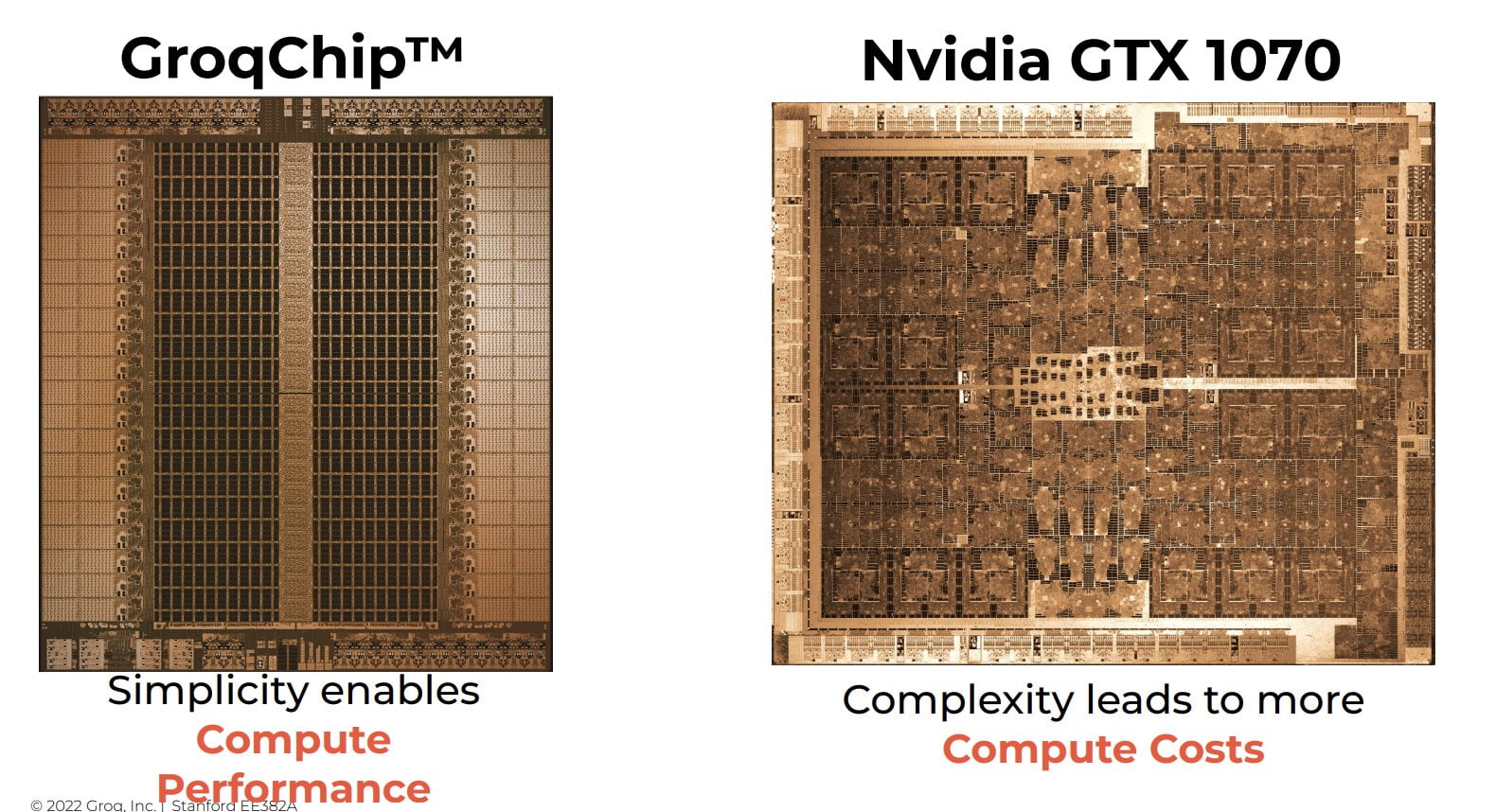

與 Nvidia 等成熟玩家相比,Groq 的 LPU 引擎之所以如此快速,是因為它完全建立在不同的方法上。

根據首席執行官 Jonathan Ross 的說法,Groq 首先創建了軟件堆和編譯器,然後設計了硅片。它採用軟件優先的思維方式,使性能變得「確定性」,這是在 AI 推理中獲得快速、準確和可預測結果的關鍵概念。

至於 Groq 的 LPU 架構,它類似於 ASIC 芯片(特定應用集成電路)的工作方式,並且是在 14nm 節點上開發的。它不是一個通用的芯片,用於各種複雜任務,而是專為處理大型語言模型中的數據序列而定制的。而 CPU 和 GPU 則可以做更多的事情,但也會導致性能延遲和增加延遲。

並且憑藉著精心設計的編譯器,該編譯器確切地知道指令週期在芯片中的運作方式,進一步減少了延遲。編譯器將指令分配到正確的位置,進一步減少了延遲。別忘了,每個 Groq LPU 芯片都搭載了 230MB 的片上 SRAM,以提供高性能、低延遲和更好的效能。

至於 Groq 芯片是否可以用於訓練 AI 模型,正如我上面所說,它是專為 AI 推理而建立的。它不具備任何用於訓練和微調模型所需的高帶寬記憶體(HBM)。

Groq 還指出,HBM 記憶體會導致整個系統的不確定性,這會增加延遲。所以不,你不能在 Groq 的 LPU 上訓練 AI 模型。

測試了 Groq 的 LPU 推理引擎

你可以前往 Groq 的網站(https://groq.com/)體驗這種極快的性能,無需帳戶或訂閱。目前,它提供了兩個 AI 模型,包括 Llama 70B 和 Mixtral-8x7B。

Groq 的 LPU 以每秒 527 個標記的速度生成了出色的輸出,在 7B 模型上僅用 1.57 秒生成了 868 個標記(3846 個字符)。在 70B 模型上,速度降至每秒 275 個標記,但仍然遠高於競爭對手。

與其他服務提供商相比,ray-project 進行了廣泛的 LLMPerf 測試,發現 Groq 的性能遠優於其他提供商。

Groq vs Nvidia:Groq 有何說法?

在一份報告中,Groq 表示其 LPUs 具有可擴展性,可以使用光學互連在 264 個芯片之間進行連接。它還可以使用交換機進一步擴展,但這會增加延遲。根據首席執行官 Jonathan Ross 的說法,該公司正在開發可以橫跨 4,128 個芯片的集群,該集群將於 2025 年發布,並且它是在三星的 4nm 工藝節點上開發的。

在一項由 Groq 執行的基準測試中,使用 576 個 LPUs 的 70B Llama 2 模型進行 AI 推理,所花費的時間只有 Nvidia H100 GPU 集群的十分之一。

不僅如此,Nvidia GPU 在生成回應的標記時耗費了 10 焦耳至 30 焦耳的能量,而 Groq 只需 1 焦耳至 3 焦耳。總結來說,該公司表示,Groq 的 LPUs 在 AI 推理任務中提供了 10 倍更快的速度,而成本僅為 Nvidia GPU 的十分之一。