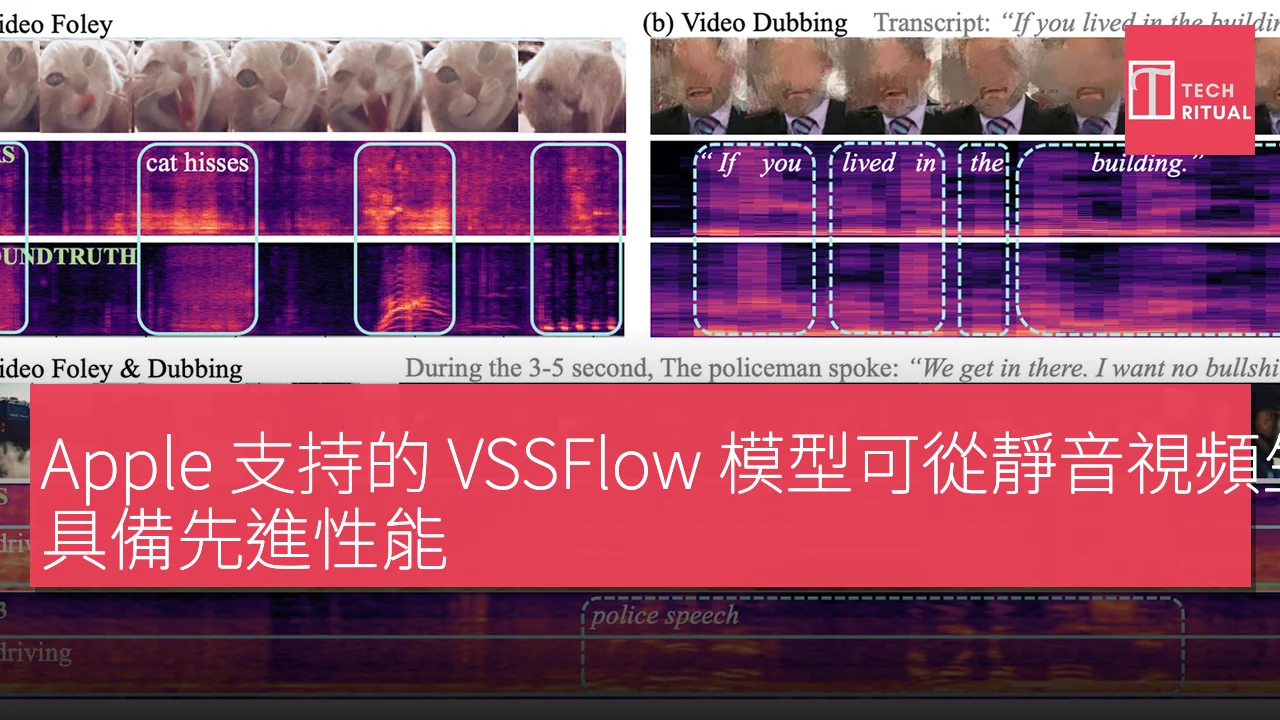

新型號 VSSFlow 採用創新的架構,能夠以單一系統生成聲音和語音,且性能表現相當出色。以下將展示一些示範影片。當前大部分的視頻轉聲音模型,雖然能夠從靜音視頻中生成聲響,但在生成語音方面的表現仍然不盡人意。同樣,大多數文本轉語音模型在生成非語音聲響時也存在不足,因為它們的設計初衷不同。

過往嘗試將這兩項任務統一的研究,往往假設聯合訓練會降低性能,導致這些模型在不同階段分別教學,增加了流程的複雜度。基於此情況,三位來自 Apple 的研究人員與六位來自中國人民大學的研究人員共同開發了 VSSFlow,這是一種能夠在單一系統中同時生成聲效和語音的新型 AI 模型。

這款模型的架構設計使得語音訓練能夠促進聲音訓練,反之亦然,而不會互相干擾。簡而言之,VSSFlow 結合了多種生成 AI 的概念,包括將逐字稿轉換為音素序列,以及通過流匹配從噪音中重建聲音,這些都嵌入在一個具有十層架構的模型中,直接將視頻和逐字稿信號融合於音訊生成過程中。

更有趣的是,研究人員指出,對語音和聲音的聯合訓練實際上提高了這兩項任務的性能,而不是造成彼此競爭或降低整體表現。為了訓練 VSSFlow,研究人員向模型提供了一組靜音視頻,這些視頻與環境聲音(V2S)、靜音對話視頻及其逐字稿(VisualTTS),以及文本轉語音數據(TTS)相配對,讓模型在單一的端到端訓練過程中同時學習聲效和對話內容。

值得注意的是,VSSFlow 在初始狀態下無法同時自動生成背景聲和對話,因此研究人員對已訓練的模型進行了微調,使用大量合成範例,使語音和環境聲音的混合學習同時進行,讓模型能夠學習到二者的搭配。為了從靜音視頻中生成聲音和語音,該模型從隨機噪音開始,利用每秒十幀的視頻取樣來塑造環境聲音,同時將所說的逐字稿提供精確指導。

在與專門針對聲效或語音的任務特定模型進行測試時,VSSFlow 在這兩項任務中均表現出色,在多個關鍵指標上領先,儘管其僅為單一統一系統。研究人員發佈了多個聲音、語音和聯合生成(來自 Veo3 影片)的示範結果,以及 VSSFlow 與多個替代模型的比較,感興趣的讀者可前往示範頁面查看所有結果。

此外,研究人員已將 VSSFlow 的代碼在 GitHub 上開源,並正致力於開放模型的權重,同時也在提供推理示範。未來的研究方向包括高質量視頻-語音-聲音數據的稀缺性限制了統一生成模型的發展,以及改進聲音和語音的表示方法,以保持語音細節的同時維持緊湊的維度,這些都是未來的重要挑戰。