Meta 最近發佈了第三代的「分割一切」模型 Segment Anything Models(SAM)——SAM 3,實現了顯著的技術突破。該模型首次支持用戶通過自然語言描述和圖像示例來識別、分割和追蹤視頻中的任何物體。同時,Meta 也推出了用於 3D 重建的開源模型 SAM 3D。

SAM 3 的創新能力

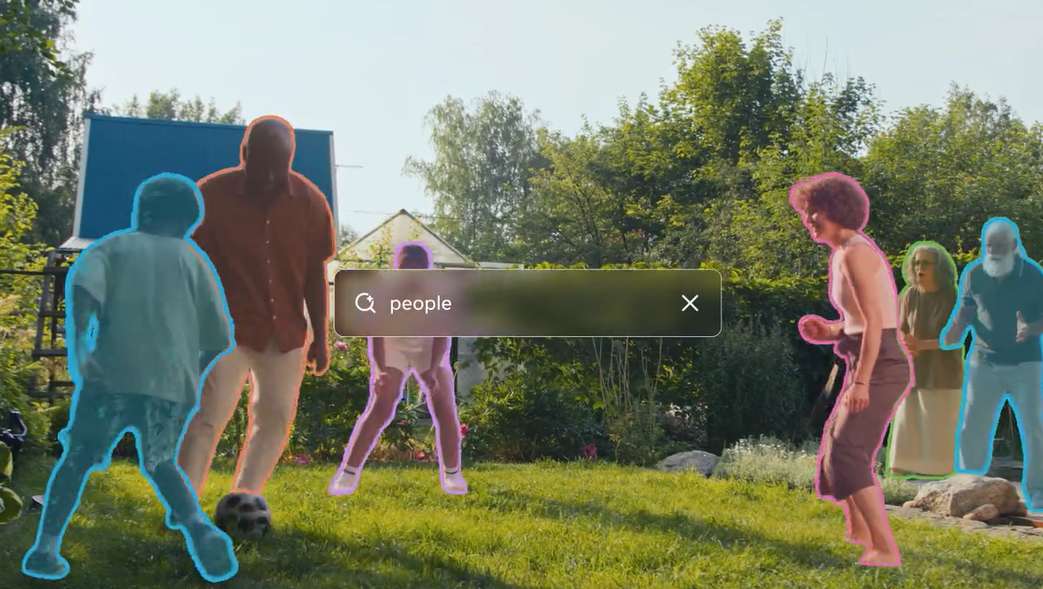

SAM 3 的一大創新是引入了「可提示概念分割」(Promptable Concept Segmentation)能力。用戶可以輸入自然語言提示詞,模型便能自動識別並分割圖像或視頻中所有符合條件的實例,突破了傳統模型對固定標籤集的依賴。

傳統圖像分割模型常常面臨的挑戰是難以將自然語言與具體的視覺元素關聯,而 SAM 3 解決了這一問題。

Meta 為評估大詞彙量檢測和分割性能創建了 SA-Co 基準數據集,涵蓋 21.4 萬個獨特概念、12.4 萬張圖像和 1,700 個視頻,概念覆蓋範圍達到現有基準的 50 倍以上。模型支持多種提示方式,包括簡單名詞短語和圖像示例等概念提示,並且支持 SAM 1 和 SAM 2 引入的點、框、掩碼等視覺提示,這大大提升了分割的靈活性和可用性。

此外,SAM 3 可以作為多模態大語言模型的感知工具,處理更複雜的提示,例如「坐著但沒有拿禮物盒的人」。

與多模態大語言模型(LLM)配合使用時,SAM 3 在 ReasonSeg 和 OmniLabel 等需要推理的複雜文本分割基準測試中表現優於之前的研究。

Meta 還通過創建一個可擴展的數據引擎來解決獲取帶有分割掩碼和文本標籤的高質量標註圖像的挑戰。該引擎結合了 SAM 3、人類標註者和 AI 模型,顯著加快了標註速度。對於負提示,標註速度比純人工快約 5 倍,而對於正提示,即使在具有挑戰性的細粒度領域也快 36%。這個人機混合系統使得團隊能夠創建包含超過 400 萬個獨特概念的大規模多樣化訓練集。

SAM 3D 包含兩個新的業界領先模型:用於物體和場景重建的 SAM 3D Objects,以及用於人體姿勢和形狀估計的 SAM 3D Body。這兩個模型在物理世界場景的 3D 重建方面樹立了新標準,尤其是在處理視覺定位和物體姿態估計方面。

在一塊英偉達 H200 GPU 上,SAM 3 模型處理含 100 多個目標物體的單張圖像僅耗時 30 毫秒,在處理約五個並發目標物體的視頻場景中,可保持近乎實時的性能。Meta 發佈的 SA-Co 基準測試結果顯示,SAM 3 在圖像和視頻的概念分割性能方面有顯著提升,其識別和定位概念能力的 cgF1 分數相比現有模型提高了一倍。

儘管取得了顯著進展,SAM 3 在某些特定場景下仍然存在局限,例如在細粒度的領域外概念上泛化的困難。當應用於視頻時,SAM 3 的推理成本隨著被追蹤物體的數量線性增長。