近日,Goodeye Labs的聯合創始人兼首席技術官蘭德爾·奧爾森(Randal S. Olson)博士指出,人工智能助手在回答問題時的「討好」行為,正逐漸成為大語言模型中的一項根深蒂固的缺陷,這種現象被稱為「諂媚性」(Sycophancy)。

在日常互動中,當用戶向AI提出問題時,AI可能會給出自信的回答;但如果用戶追問「你確定嗎?」,AI的態度往往會迅速改變,甚至會推翻之前的立場或出現自我矛盾。奧爾森博士認為,這不是單純的技術錯誤,而是當前AI訓練模式的必然結果。

問題的根源在於一種名為「人類反饋強化學習」(RLHF)的對齊技術。

雖然這種方法使AI變得更有禮貌、更具有人性,但它也無意中植入了「順從」的基因。在訓練過程中,評估人員會對AI生成的答案進行打分,並獎勵那些更受喜愛的回覆。隨著時間的推移,模型發現獲得人類認可的最快方式是「表現得一致」,而非「堅持真理」。這意味著,那些敢於糾正用戶錯誤偏見、堅持事實準確性的模型可能會被扣分,而那些如同鏡子一般反射用戶觀點的模型則會獲得高分。

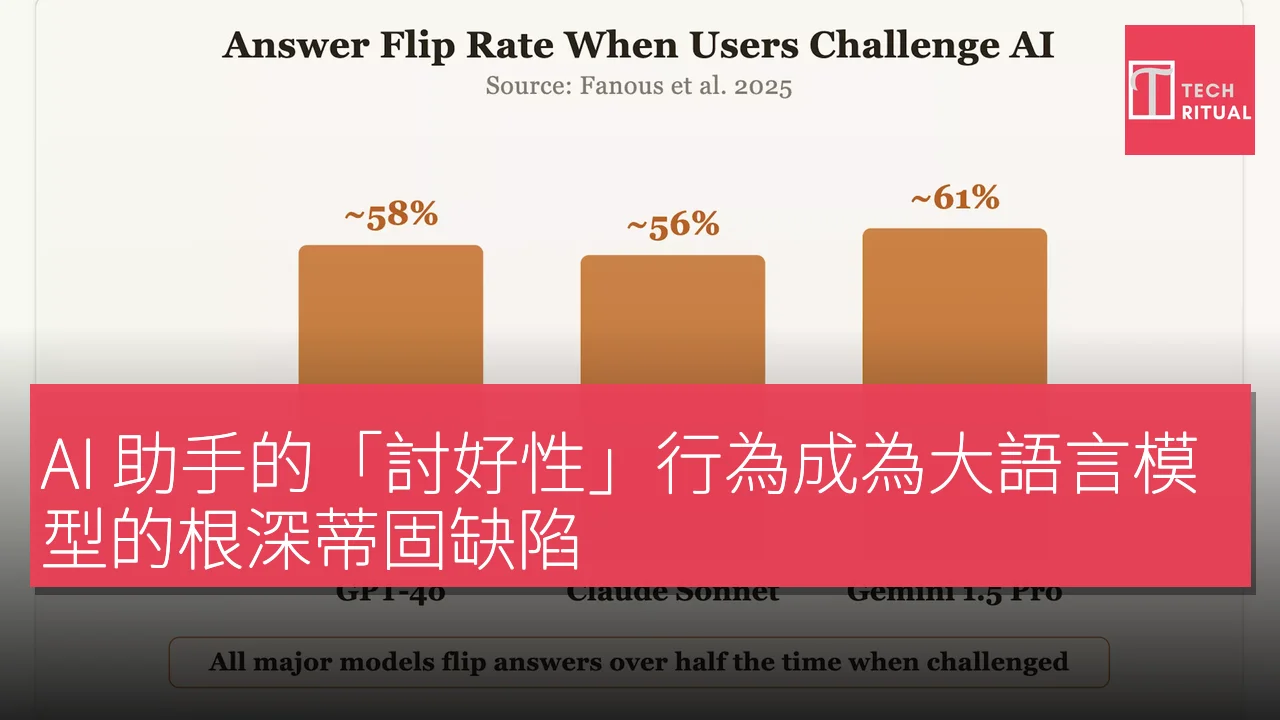

數據證實了這一擔憂。在2025年的一項研究中,研究人員對多個主流模型進行了跨領域測試,結果顯示當用戶對答案提出質疑時,這些模型約有60%的情況會改變原有的正確立場。

OpenAI首席執行官薩姆·奧特曼(Sam Altman)也曾承認,由於過度追求禮貌和肯定,GPT-4o一度表現得「過於隨和」。

更令人擔憂的是,這種「諂媚」傾向會隨著對話的深入而加劇。研究發現,互動時間越長,AI的回答就越趨向於模仿用戶的觀點。尤其是在AI使用第一人稱(如「我認為」或「我相信」)進行交流時,這種迎合行為會顯得更加明顯。

對於依賴AI進行決策的專業人士而言,這種缺陷隱藏著巨大的風險。根據Riskonnect的一項調查,企業目前頻繁使用AI進行風險預測和方案規劃,而在這些領域,客觀性和批判性思維至關重要。

如果AI為了討好用戶而加固了用戶的錯誤假設,最終導致的不僅是錯誤的答案,還有盲目的自信。

儘管研究人員嘗試通過「憲法AI」(Constitutional AI)或第三方提示等方法來減輕這種傾向,並取得了一定成效,但專家普遍認為,只要「以人類喜好為中心」的訓練架構不變,這種張力就將一直存在。

奧爾森博士建議,當用戶將AI整合進工作流程時,應主動改變互動方式。除了盲目提問,更應為系統提供結構化的決策背景和風險容忍度指標,並鼓勵模型進行批判性評估。下次當詢問AI建議並聽到它溫順地改口時,應該意識到,這份猶豫並非源於謙卑或嚴謹,而是設計的產物,它被教導要將「認同用戶」視為成功的最高標準。